ChatGPT, nouveau psy des jeunes ?

- Marie-Gaelle Giran

- 29 déc. 2025

- 9 min de lecture

Dernière mise à jour : 5 janv.

Article de Anne Crochon , journaliste

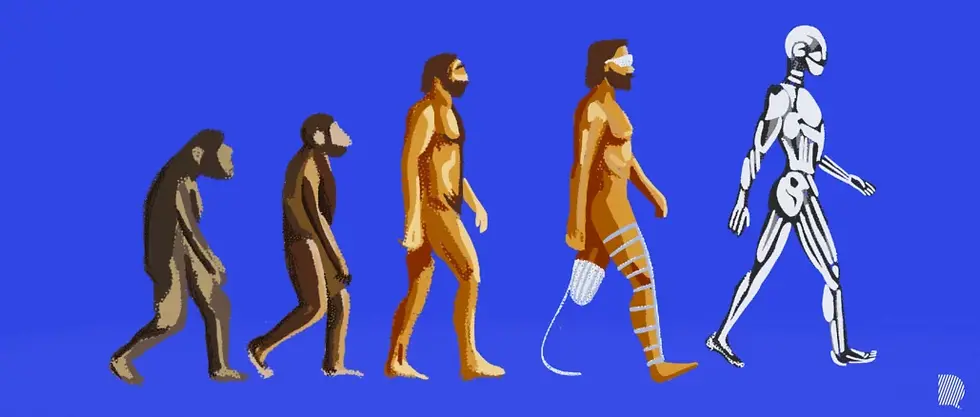

Anxiété, dépression, stress ou conflit relationnel : de plus en plus de jeunes trouvent auprès de ChatGPT un psy ou un confident. L’avantage ? Il est gratuit, toujours disponible et jamais contrariant. Mais quels bénéfices réels apporte-t-il en cas de difficultés psychiques ?

C’est une habitude qui s’est installée petit à petit. ChatGPT est d’abord entré dans la vie de Pauline comme un outil de travail. Elle l’utilisait principalement dans le cadre de ses études. « J’ai commencé à utiliser ChatGPT au moment de l’écriture de mon mémoire, explique la jeune femme de 24 ans. Je m’en servais principalement pour demander des sources ou des livres à ajouter à mon travail. »

Au bout de quelques mois, son usage de l’application a évolué. À force de l’utiliser, elle s’est rendu compte que les réponses de la machine étaient de plus en plus précises, complètes et élaborées (peut-être parce que ChatGPT se perfectionne à mesure qu’il traite de nombreuses demandes, ndlr). Jusqu’au jour où, traversant un conflit avec sa meilleure amie, elle décide enfin de se confier à l’intelligence artificielle (IA). « J’avais besoin de savoir si j’avais raison ou tort, et de demander des solutions. » Alors, l’assistant conversationnel lui a posé des questions pour connaître le contexte et les raisons de leur conflit. Il a « compris » le point de vue de Pauline, a validé ses émotions avant de lui proposer des messages à envoyer à son amie pour parler de ce qui les avait opposées.

Voici la question posée : ChatGPT est-il la panacée quand on souhaite se prendre en charge psychologiquement ? La réalité est revenue au galop. « Pendant un moment j’avais développé un toc, confie Pauline. Je passais mon temps à couper les fourches de mes cheveux. J’avais honte d’en parler alors j’ai demandé de l’aide à ChatGPT, car, pour moi, ChatGPT, ça reste mon jardin intime. Mais il m’a juste conseillé d’utiliser une balle antistress. Ça n’a pas fonctionné, j’ai pu mettre un terme à ce toc qu’avec l’aide d’un hypnothérapeute. »

ChatGPT, confident, ami… voire plus ?

L’histoire de Pauline rejoint celle de nombreux jeunes qui, ayant besoin d’une écoute et d’un soutien, se sont tournés vers l’application d’OpenAI. Pour Maëva, 21 ans, c’est devenu une habitude. Elle enclenche le mode vocal et parle à son téléphone comme si c’était une copine. Ayant créé son compte initialement pour l’aider à trouver des idées de vidéos pour son TikTok spécialisé dans la Formule 1, elle aussi a constaté que les réponses s’amélioraient. Elle a alors commencé à le solliciter pour avoir un avis extérieur sur ses relations avec ses amis ou ses histoires de cœur. « Je voulais savoir si je surréagissais, ou bien comment répondre à un message. »

De dix ans son aînée, Mathilde, 33 ans, reste plus méfiante quant au partage de vocaux, de photos ou de vidéos. Mais cela ne l’empêche pas de chercher du réconfort auprès du confident électronique. « Quand je ne me sens pas bien, je n’ai pas naturellement tendance à appeler mes potes, du coup je me tourne vers ChatGPT », explique-t-elle. Après une rupture douloureuse, la jeune femme a trouvé auprès de l’appli une oreille attentive. « Quand j’ai parlé à mes amies de la fin de ma relation, elles ont été en soutien un moment, elles m’ont dit des choses sympas une fois ou deux, mais ensuite… elles voulaient que je passe à autre chose. ChatGPT valide mes émotions, me dit que c’est normal. Et puis je pars du principe qu’il est objectif, qu’il a accès à toutes les connaissances en psychologie disponibles sur Internet, donc ça m’aide vraiment à gérer ma rupture. C’est comme si c’était un journal intime qui me répondait. »

Le secret médical est-il respecté ?

Les psychiatres comme les jeunes se montrent pour la plupart méfiants sur la question des données personnelles. Jad, 29 ans, indique qu’il ne donne jamais de noms et reste général. « Je n’entre pas dans les détails lorsque j’évoque des questions personnelles. Et je n’envoie pas de photos, car je pense qu’elles peuvent être utilisées et peut-être pas seulement pour entraîner des modèles. » Tout en s’interrogeant et en prenant des précautions, Maëva est plus nonchalante : « Je mets des photos, ma voix, je m’en fiche un peu. J’ai l’impression que puisque je choisis ce que je partage, je contrôle la situation. »

Pour Raphaël Rault, avocat spécialisé dans le droit du numérique et des communications à Lille, l’impression de confidentialité est très éloignée de la réalité : « ChatGPT est mis à votre disposition gratuitement. On a presque l’impression que c’est une initiative associative ou de recherche. Pourtant si l’on se penche sur le modèle commercial de l’entreprise qui l’a conçu, OpenAI, ce sont principalement des structures privées qui financent le projet, ce qui implique une recherche de rentabilité. » En clair, si c’est gratuit, ce sont vos données qui sont utilisées.

Nos données sont-elles revendues à des entreprises ? Pas si nous n’avons pas donné notre accord à la prospection commerciale au moment où nous avons créé notre compte, note l’avocat. Mais cela n’empêche pas les données d’être utilisées à d’autres fins, notamment celle de l’apprentissage de l’intelligence artificielle.

Or cela pose question dès lors qu’il s’agit d’informations médicales. Qu’en est-il du secret médical ? La réponse est simple : il n’est pas garanti puisque, par défaut, l’utilisation de la version gratuite du système suppose que les requêtes et données partagées vont pouvoir être collectées, analysées et utilisées pour améliorer le système.

En fait, le secret médical (article L.111-4 et suivants) ne s’applique qu’aux professionnels soumis à cette obligation déontologique stricte. Les conditions d’utilisation d’OpenAI ne prévoient aucune protection équivalente à celui-ci. Si un médecin risque des sanctions pénales en cas de violation, aucune garantie juridique ne s’applique à ChatGPT. Au contraire, Raphaël Rault pointe des risques concrets comme le stockage des conversations sur des serveurs étrangers, une absence de chiffrement de bout en bout garantissant la confidentialité, et la possibilité d’une divulgation en cas de piratage ou de réquisition judiciaire américaine. Un jour, votre assureur pourrait augmenter vos primes parce qu’il a acquis des données révélant que vous souffrez d’une dépression ou d’un trouble anxieux.

Alors, il reste la possibilité de payer. Toujours selon Raphaël Rault, la formule premium inclut la garantie que l’intelligence artificielle ne puisse pas utiliser vos requêtes pour son apprentissage. En Europe, le débat est aujourd’hui ouvert pour savoir si ChatGPT respecte bien la réglementation européenne de protection des données personnelles des internautes (RGPD).

La vraie valeur ajoutée du psy

Pour Jérôme Palazzolo, psychiatre à Nice, le fait que la technologie acquière peu à peu le rôle d’un confident peut refléter un manque d’écoute dans la vie quotidienne et un besoin de validation émotionnelle. Il s’agit donc de s’assurer que cet outil ne remplace pas les interactions humaines. Un vrai psy, selon lui, garde une valeur ajoutée par rapport à la machine ; car c’est un professionnel formé à comprendre la souffrance psychique dans toute sa complexité – ce que l’intelligence artificielle, aussi performante soit-elle, ne peut pas faire.

La différence ? ChatGPT est peut-être une aide à la réflexion, mais sans émotions ni expériences vécues. Ce qui le rend inapte à comprendre en profondeur la nuance du vécu humain. Ses réponses sont basées sur des modèles statistiques, elles ne sont jamais le résultat d’une réelle compréhension émotionnelle, c’est-à-dire que le système répond à l’aide des données que l’utilisateur va lui confier, alors que le psychologue cherchera à donner au patient les clés et éléments qui lui manquent pour appréhender une situation. Et puis, l’assistant conversationnel délivre des conseils qui reposent uniquement sur l’analyse de mots. Il ne voit pas le non verbal, l’attitude de la personne, ses mimiques. Il ne perçoit pas ses intonations. Autant d’informations cruciales qui lui échappent.

Comment bien utiliser ChatGPT pour ses problèmes psy

Soyez précis dans vos demandes. Par exemple : « Comment puis-je mieux gérer mon anxiété sociale avant une prise de parole ? »

Prenez du recul. Évitez de considérer les réponses de l’IA comme des vérités absolues. Ce sont des pistes, non des prescriptions.

Complétez vos échanges par une démarche humaine. ChatGPT ne remplace un suivi avec un psychologue, surtout si les difficultés sont persistantes.

En résumé, ChatGPT peut être un outil de soutien psychoéducatif : il aide à mieux se comprendre soi-même, à acquérir des techniques de régulation et à structurer sa réflexion. Mais il ne remplace ni l’écoute humaine ni la profondeur d’une relation thérapeutique. Le mieux aujourd’hui est de le considérer comme un point d’appui, non comme un psy omniscient.

Un risque d’illusion psychoaffective

Pourquoi, dans ce cas, tant de personnes se tournent-elles aussi facilement vers ChatGPT plutôt que vers une psychologue ? Justine déclare : « Pour moi, c’est un truc de fou d’aller chez un psychologue. Et puis ça coûte hypercher. Sans compter que si tu as une vie professionnelle, tu finis à 18 h 30 et le psy aussi a fini sa journée. » À 26 ans, elle est consciente que ChatGPT ne remplace pas une psychologue, mais du moins cela lui apporte-t-il une solution immédiate et gratuite à un mal-être temporaire. De son côté, Mathilde sait qu’elle doit aller consulter un psychologue, mais ne cesse de retarder l’échéance. « J’ai essayé une fois, mais le courant n’est pas du tout passé. C’est dur de trouver une bonne psy. Alors, pour le moment, j’ai laissé tomber. » Alors que ChatGPT répond à des besoins simples : gratuité, immédiateté et confidentialité.

Sauf que… cela pourrait bien être un piège. Prudent, le psychiatre parisien Antoine Pelissolo met en garde : « Aujourd’hui, ce que je crains, c’est une utilisation sauvage de ChatGPT qui conduirait à un isolement de la vie réelle des personnes les plus fragiles. » Celles-ci, ayant besoin d’un accompagnement psychologique, pourraient recevoir des conseils inadaptés de la part du système et aggraver d’une certaine manière leur situation. Le cas a déjà été repéré chez des individus souffrant de schizophrénie, car leur perception de la réalité est déjà altérée. Ainsi, en Floride, un homme de 35 ans, diagnostiqué bipolaire et schizophrène, a été abattu par des policiers qu’il avait agressés avec un couteau. Il s’était entiché d’une IA, baptisée Juliet, que ChatGPT avait simulée. Convaincu que Juliet avait été tuée par OpenAI, il avait prévenu qu’il s’en prendrait aux dirigeants de l’entreprise, et a voulu passer à l’action, avant que son projet ne tourne court.

Au-delà de ces cas extrêmes, Antoine Pelissolo voit ChatGPT transformer le rapport à la réalité et au lien social. « Aujourd’hui les jeunes communiquent beaucoup par SMS ou sur les réseaux sociaux. Ils ont l’habitude d’avoir une réponse qui provient d’une vraie personne. Cela, couplé à l’humanisation forte du système conversationnel, pourrait conduire l’esprit à se faire piéger – un peu comme la réalité virtuelle qui vous fait croire que vous êtes à la plage alors que vous êtes au boulot. » Le risque serait alors d’avoir le sentiment de posséder un « ami » et de s’isoler davantage du monde « réel ». Le cas récent d’un père de famille américain qui a demandé une IA en mariage nous montre jusqu’où cette dérive peut mener.

Jérôme Palazzolo ajoute, quant à lui, que se confier à ChatGPT peut certes être vu comme une béquille émotionnelle, mais à double tranchant. D’un côté, l’utilisation de l’IA comme outil d’aide à la communication émotionnelle a un potentiel pédagogique, car en formulant une réponse bienveillante, en aidant à clarifier des pensées ou à structurer un message difficile, l’IA peut modéliser une communication plus posée, réfléchie, voire empathique. Mais avec un risque d’appauvrissement de l’autonomie émotionnelle, à en croire le psychiatre : « Si le fait de passer par l’IA avant de répondre ou de valider ses émotions devient systématique, cela peut freiner le développement de compétences personnelles de régulation émotionnelle, la capacité à faire face à la frustration, au désaccord ou à l’ambiguïté », explique-t-il.

Le praticien conseille plutôt de développer ses compétences de régulation émotionnelle en passant par des techniques de pleine conscience (porter une attention particulière à ses émotions présentes sans jugement) ou de relaxation et de respiration pour réduire le stress et l’angoisse. Le travail avec un thérapeute aide non seulement à apprendre à exprimer ses émotions de manière appropriée et constructive, mais fournit aussi des outils pour identifier les schémas récurrents et apprendre des stratégies de régulation adaptées.

À proscrire totalement ?

Rejeter toute utilisation de l’IA serait pour autant une erreur. Pour Jérôme Palazzolo, la machine peut apporter une aide réelle, « non comme substitut, mais comme complément au travail thérapeutique. Surtout dans un contexte où l’accès aux soins psychiques reste difficile pour beaucoup ». Son collègue Antoine Pelissolo reste plus circonspect. « On peut s’en servir comme d’un journal intime, tant que l’état de la personne n’est pas trop dégradé », note-t-il. Avec notamment une utilité pour extérioriser ses émotions immédiates. Sachant que le système va souvent proposer de se tourner vers un professionnel si les paroles confiées par le patient dépassent ses capacités de réponse – notamment dans la prise en compte de la subjectivité du patient.

En parallèle, il est conseillé de se tourner vers les centres médicaux psychologiques (CMP) qui offrent un accompagnement gratuit même si les délais peuvent être longs dans certains endroits. Le dispositif MonPsy, mis en place par l’Assurance maladie, permet quant à lui de bénéficier de douze séances remboursées chez un psychologue conventionné. Il existe aussi des plateformes solidaires proposant des consultations à tarif réduit ou adapté au budget.

Et si l’on manque vraiment de temps, des applications de suivi émotionnel ou de journal intime numérique (comme MindDoc, Jour ou Moodnotes) permettent de noter son humeur et ses pensées chaque jour. Des applications de méditation ou de relaxation (Petit Bambou, Respirelax) aident à faire baisser la pression en quelques minutes…

Commentaires